英伟达重磅发布:144核超级Arm CPU及800亿晶体管的超级GPU!

2022-03-23 12:01:56 EETOP其中最为引人关注的是最新Hopper架构的H100 GPU系列及144核超级Arm CPU。

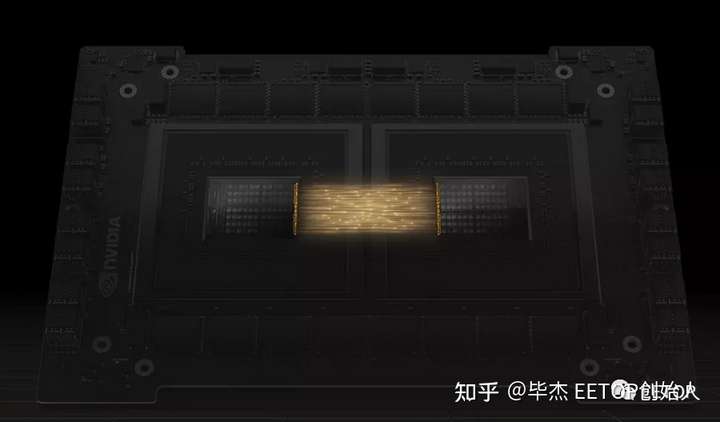

先进的小芯片互联技术

为了便于更好的文章内容,我们先介绍一下英伟达的最新推出的芯片互联技术NVLink-C2C。

这是一种支持内存一致性的芯片到芯片互连技术。NVLink-C2C 可提供高达 25 倍的能效,比 Nvidia 目前使用的 PCIe 5.0 PHY 的面积效率高 90 倍,支持高达 900 GB/s 或更高的吞吐量。该接口支持 CXL 和 Arm 的 AMBACHI 等行业标准协议,并支持从基于 PCB 的互连到硅中介层和晶圆级实现的各种连接。令人惊讶的是,Nvidia 现在允许其他供应商将该设计用于他们自己的小芯片。此外,Nvidia 宣布将支持新的 UCIe 规范。

NVLink-C2C 现在将覆盖 Nvidia 的所有芯片,包括 GPU、CPU、SOC、NIC 和 DPU。Nvidia 还表示,它正在开放规范以允许其他公司在其小芯片设计中使用 NVLink。这为客户提供了使用 UCIe 接口或 NVLink 的选项,尽管 Nvidia 声称 NVLink-C2C 已针对比 UCIe 更低的延迟、更高的带宽和更高的能效进行了优化。

比如英伟达利用NVLink-C2C可将两个Grace CPU互联在一起组成144核的超级CPU - Grace CPU Superchip (CPU+CPU)。也可以将单片Grace CPU与Hopper GPU互联(CPU+GPU),组成Grace Hopper Superchip.

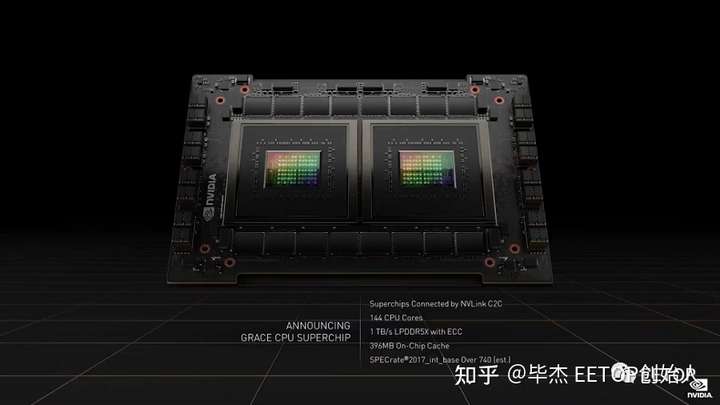

144核超级CPU: Grace CPU Superchip

Grace CPU Superchip是该公司第一款专为数据中心设计的纯 CPU 的 Arm 芯片。基于 Neoverse 的架构,支持 Arm v9,并通过Nvidia 新的 NVLink-C2C 互连技术将两个72核心的Hopper CPU融合在一起(CPU+CPU),提供一致的 900 GB/s 连接,组成144核的Grace CPU Superchip。此外,基于 Arm v9 Neoverse的芯片支持 Arm 的 Scalable VectorExtensions (SVE),这是一种性能提升的 SIMD 指令,其功能类似于 AVX。

两个 Grace CPU 通过 Nvidia 新的 NVLink 芯片到芯片 (C2C) 接口进行通信。这种芯片到芯片和芯片到芯片的互连支持低延迟内存一致性,允许连接的设备同时在同一个内存池上工作。Nvidia 使用其 SERDES 和 LINK 设计技术制作接口,重点是能源和面积效率。

Nvidia 声称 Grace CPUSuperchip 在 SPEC 基准测试中提供的性能比其自己的 DGX A100 服务器中的两个上一代 64 核 AMD EPYC 处理器高出 1.5 倍,并且是当今领先服务器芯片的两倍。

老黄声称 Grace CPUSuperchip 将于 2023 年初出货,将成为市场上最快的处理器,适用于超大规模计算、数据分析和科学计算等广泛的应用。

鉴于我们对 Arm 路线图的了解,该芯片基于 N2 Perseus 平台,这是第一个支持 Arm v9 的平台。该平台采用 5nm 设计,支持所有最新的连接技术,如 PCIe Gen 5.0、DDR5、HBM3、CCIX 2.0 和 CXL 2.0,比 V1 平台提供高达 40% 的性能。

考虑到 Grace CPU Superchip 的两个 CPU 和板载内存都消耗 500W 的峰值功率,这很有意义。这与其他领先的 CPU 具有竞争力,例如 AMD 的 EPYC(霄龙),每个芯片的最高功率为 280W(这不包括内存功耗)。

Nvidia 声称 Grace CPU 在市场上的效率将是竞争 CPU 的两倍。每个 CPU 都可以访问自己的 8片LPDDR5X,因此这两个芯片仍然会受到近远内存的标准 NUMA 类趋势的影响。尽管如此,两个芯片之间增加的带宽也应该有助于减少由于竞争减少而导致的延迟,从而实现非常有效的多芯片实现。该设备还配备了 396MB 的片上缓存,但尚不清楚这是用于单个芯片还是两者兼有。

Grace CPU Superchip 内存子系统提供高达 1TB/s 的带宽,Nvidia 称这是 CPU 的首创,是支持 DDR5 内存的其他数据中心处理器的两倍多。LPDDR5X 共有 16 个封装,可提供 1TB 容量。此外,Nvidia 指出,Grace 使用了 LPDDR5X 的第一个 ECC 实现。

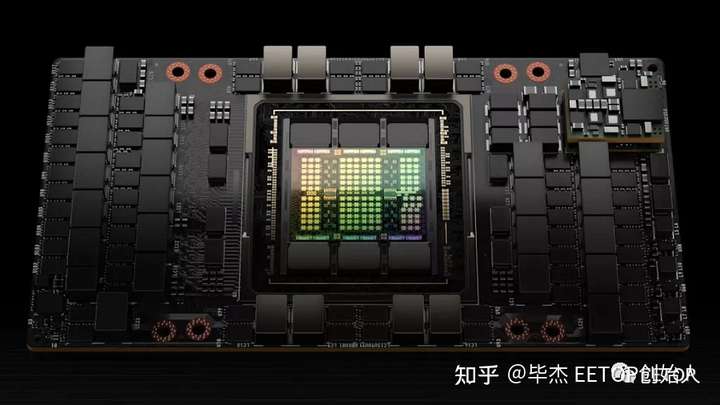

集成800亿晶体管,英伟达发布新一代GPU,台积电专属4nm

今天,在其 GPU 技术大会 (GTC) 上,Nvidia 透露了其 Hopper 架构和 Nvidia H100 GPU的详细信息。

我们知道 Nvidia 致力于下一代 GPU 已经有一段时间了,但现在我们有了一些具体的规格。不要将 Hopper 架构和 H100 GPU 与 Ada 混淆,后者是以消费者为中心的架构,将为未来的 GeForce 卡提供动力。

Nvidia 尚未透露有关 Ada 的任何细节,Hopper H100 将取代 Ampere A100,后者本身取代了 Volta V100。这些都是数据中心部件,并且与来自 AMD 的Instinct MI250/250X和新发布的Instinct MI210等公司的激烈竞争,Nvidia 正在寻求重新夺回 HPC 的领先地位。正如您所期望的那样,H100 专为超级计算机设计,专注于 AI 功能。与当前的 A100 相比,它包括许多更新和升级,所有设计都达到了新的性能和效率水平。

Hopper 包含 800 亿个晶体管(A100 GPU“仅”有 540 亿个晶体管)。它是使用定制的 TSMC 4N 工艺制造的——这是为 4nm Nvidia 设计的,这不要与 TSMC 提供的通用 N4 4nm 工艺混淆。

英伟达没有透露核心数量或时钟频率,但确实提供了一些其他细节。H100 支持 Nvidia 的第四代 NVLink 接口,可提供高达 128 GB/s 的带宽。它还支持不使用 NVLink 的系统的 PCIe 5.0,最高速度为 128 GB/s。更新后的 NVLink 连接提供的带宽是 A100 的 1.5 倍,而 PCIe 5.0 提供的带宽是 PCIe 4.0 的两倍。

H100 还将默认支持 80GB 的 HBM3 内存,带宽为 3 TB/s,比 A100 的 HBM2E 快 1.5 倍。虽然 A100 有 40GB 和 80GB 两种型号,后者在生命周期的后期推出,但 H100 和 A100 仍然使用多达六个 HBM 堆栈,显然禁用了一个堆栈(即使用虚拟堆栈)。

一般来说,H100 的内存和接口带宽比其前代产品多 50%。可以肯定,这是一个很好的改进,但 Hopper 的其他方面涉及更大的增长。H100 可提供高达 2,000 TFLOPS 的 FP16 计算和 1,000 TFLOPS 的 TF32 计算,以及 60 TFLOPS 的通用 FP64 计算——在所有三种情况下,这都是 A100 性能的三倍。Hopper 还增加了改进的 FP8 支持,计算能力高达 4,000 TFLOPS,比 A100 快六倍(由于缺乏原生 FP8 支持,它不得不依赖 FP16)。为了帮助优化性能,Nvidia 还拥有一个新的转换器引擎,它将根据工作负载在 FP8 和 FP16 格式之间自动切换。

Nvidia 还将添加旨在加速动态编程的新 DPX 指令。这些可以帮助广泛的算法,包括路线优化和基因组学,Nvidia 声称这些算法的性能比其上一代 GPU 快 7 倍,比基于 CPU 的算法快 40 倍。Hopper 还包括提高安全性的更改,多实例 GPU (MIG) 现在允许在单个 H100 GPU 上运行七个安全租户。所有这些变化对于英伟达的超级计算和人工智能目标都很重要。然而,这些变化并非都是好的。尽管转向较小的制造节点,但 SXM 变体的 H100 TDP 已增加到 700W,而 A100 SXM 模块的 TDP 为 400W。这增加了 75% 的功率,改进范围似乎在 50% 到 500% 之间,具体取决于工作负载。

总的来说,我们预计性能将比英伟达 A100 快两到三倍,因此效率仍应有净提升,但这进一步证明了摩尔定律正在放缓。总体而言,英伟达声称 H100 的扩展性优于 A100,并且可以在 AI 训练中提供高达 9 倍的吞吐量。使用 Megatron 530B 吞吐量作为基准,它还提供了 16 到 30 倍的推理性能。最后,在 3D FFT(快速傅立叶变换)和基因组测序等 HPC 应用程序中,Nvidia 表示 H100 比 A100 快 7 倍。

Nvidia DGX H100、Superpods 和 Eos 超级计算机

当然,Nvidia H100 GPU 只是故事的一部分。与 A100 一样,Hopper 最初将作为新的 DGX H100 机架式服务器提供。每个 DGX H100 系统包含 8 个 H100 GPU,可提供高达 32 PFLOPS 的 AI 计算和 0.5 PFLOPS 的 FP64,以及 640GB 的 HBM3 内存。DGX H100 alos 具有 3.6 TB/s 的二等分带宽。

使用多台 DGX H100 服务器,Nvidia 可以扩展到具有 32 个 DGX H100 系统的 DGX SuperPod,并与更新的 NVLink 交换机系统和 Quantum-2 InfiniBand 网络连接在一起。因此,单个 H100 SuperPod 具有 256 个 H100 GPU、20TB 的 HBM3 内存和高达 1 ExaFLOPS 的 AI 计算潜力。它还提供 70.4 TB/s 的带宽。

自然,超级计算机可以使用多个 SuperPod 构建,Nvidia 宣布了其新的 Eos 超级计算机,该超级计算机紧随 Selene 的脚步。Eos 将由 18 个 H100 SuperPods、576 个 DGX H100 系统和 360 个 NVLink 交换机构建而成,它将提供 275 PFLOPS 的 FP64 计算。更重要的是,在 Nvidia 专注于 AI 的未来,它将提供 18 EFLOPS 的 FP8 AI 计算,或 9 EFLOPS 的 FP16。

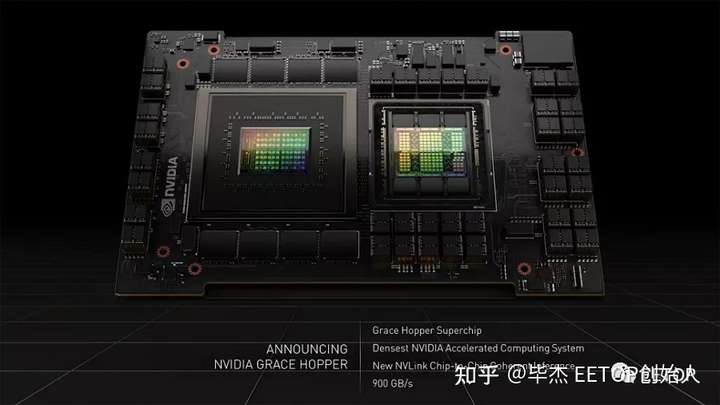

前面提到,通过英伟达最新互联技术可以将Grace CPU和Hopper GPU互联融合在一起(CPU+GPU),组成Grace Hopper Superchips。

Grace Hopper Superchip 在一个载板上有两个不同的芯片,一个 CPU 和一个 GPU。我们现在知道 CPU 有 72 个内核,使用基于 Neoverse 的设计,支持 Arm v9,并与 Hopper GPU 配对。这两个单元通过 900 GBpsNVLink-C2C 连接进行通信,提供 CPU 和 GPU 之间的内存一致性,从而允许两个单元同时访问 LPDDR5X ECC 内存池,据称带宽比标准系统提高了 30 倍。

Nvidia 最初没有公布设计中使用的 LPDDR5X 数量,但在这里我们可以看到该公司现在声称拥有“600GB 内存 GPU”,其中肯定包括 LPDDR5X 内存池。我们知道 LPDDR5X 每个封装的最高容量为 64GB,这意味着 CPU 配备了高达 512GB 的 LPDDR5X。同时,Hopper GPU 通常具有 80GB 的 HBM3 容量,使我们接近 Nvidia 的 600GB 。让 GPU 访问该数量的内存容量可能会对某些工作负载产生变革性影响,尤其是对于经过适当优化的应用程序。