刚刚,英伟达发布史上最强芯片!

2023-11-14 11:12:31 EETOP

H200 GPU 或许是这场秀的真正主角。Nvidia 没有提供所有规格的详细明细,但主要的一点似乎是每个 GPU 的内存容量和带宽大幅增加。

更新后的 H200 配备了总容量为 141GB 的 HBM3e 内存,有效运行速度约为 6.25 Gbps,六个 HBM3e 堆栈中每个 GPU 的总带宽为 4.8 TB/s。这比原来的 H100 有了巨大的改进,原来的 H100 有 80GB 的 HBM3 和 3.35 TB/s 的带宽。H100 的某些配置确实提供了更多的内存,比如 H100 NVL,它将两块板子配对使用,总共提供了 188GB 内存(每个 GPU 94GB),但与 H100 SXM 变体相比,新的 H200 SXM 内存容量增加了 76%,带宽增加了 43%。

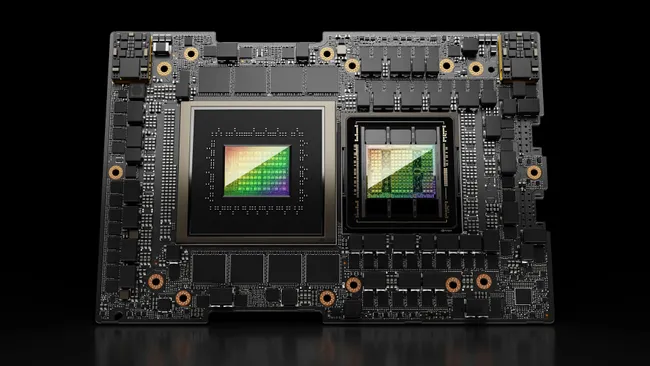

当然,这次英伟达不仅仅是宣布发布了更新的 H200 GPU。还有一种新的 GH200 也即将面世,它将 H200 GPU 与 Grace CPU 结合在一起的"超级芯片 "。每个 GH200将包含 624GB 内存。最初的 GH100 将 CPU 的 480GB LPDDR5x 内存与 96GB HBM3 内存结合在一起,而新版本则增加到了144GB HBM3e。

同样,关于 CPU 方面是否有其他变化的细节也不多,但 Nvidia 提供了 GH200 与 "现代双插槽 x86 "配置的一些比较,其中提到了与 "非加速系统 "相比的速度提升。

这意味着什么?我们只能假设 x86 服务器运行的代码没有经过完全优化,特别是考虑到人工智能世界发展迅速,优化方面似乎经常有新进展。

GH200 还将用于新的 HGX H200 系统。据说,这些系统与现有的 HGX H100 系统 "无缝兼容",这意味着 HGX H200 可以在相同的设备中使用,以提高性能和内存容量,而无需重新设计基础设施。

瑞士国家超级计算中心(Swiss National Supercomputing Center)的阿尔卑斯超级计算机(Alps supercomputer)很可能是明年投入使用的首批Grace Hopper超级计算机之一,不过该系统仍然使用 GH100。美国第一台投入使用的 GH200 系统将是洛斯阿拉莫斯国家实验室的 Venado 超级计算机。今天宣布的德克萨斯高级计算中心(TACC)Vista 系统也将使用格雷斯 CPU 和格雷斯 Hopper 超级芯片,但尚不清楚是 H100 还是 H200。

据目前所知,即将安装的最大的超级计算机是 "胡安里奇 "超级计算中心( Jϋlich Supercomputing Centre)的Jupiter超级计算机。它将容纳 "近 "24,000个GH200超级芯片,合计93 exaflops的人工智能计算能力(推测这是使用FP8的数字,尽管根据我们的经验,大多数人工智能仍然使用BF16或FP16)。它还将提供 1 exaflop 的传统 FP64 计算能力。它使用的 "quad GH200 "板具有四个 GH200 超级芯片。

总而言之,Nvidia 预计在未来一年左右的时间里,这些新安装的超级计算机将提供超过 200 exaflops 的人工智能计算性能。