技术架构揭秘:英特尔第五代至强可扩展处理器

2024-03-23 20:39:21 Nancy,EETOP当前,AI应用非常火爆。全球各种不同的调研结果都显示,有58%的企业在非常近的未来,都会导入如生成式AI到他们的生意模式当中。预计到2026年有超过3000亿美金将投入到生成式AI当中,这其中包括硬件、软件、解决方案等。而其中有50%以上的边缘应用也会采用AI技术。到2028年有80%以上的PC都会转换成AIPC,通过AI可以提升大家在PC上的生产力。还有80%以上的公司,也会在2026年之前会导入某种程度的生成式AI以提高企业生产力。

云计算时代,工作负载需要快速运行,底层硬件能力需要充分利用。对于云厂商而言,真正的核心竞争力之一在于实例的性价比。因此,效率的提升至关重要,其中的关键是效率和效能的提升。而到了AI时代,英特尔市场营销集团副总裁、中国区数据中心销售总经理兼中国区运营商销售总经理庄秉翰分享说:“我们发现数据中心的耗电量极高,一台GPU服务器可达上万瓦的功率,如果未来中国建造越来越多的数据中心,那么可持续性便是一大挑战。其实眼下数据中心的成本当中,电费占据了很大一块。”

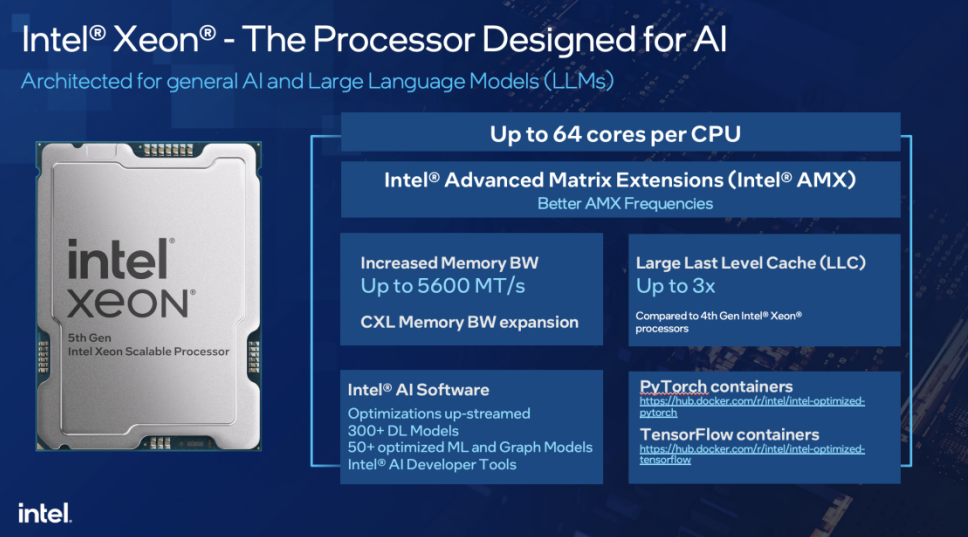

在英特尔于去年推出的第五代至强可扩展处理器上,就可看到至强产品出来产品性能的持续迭代更新之外,在节能省电、降低能耗、提高AI推理能力方面,都有极大的提升。在硬件上,第五代至强升级到Raptor Cove核心,最多拥有64个核,内存带宽高达5600MT/s,级缓存的容量提升了三倍,并通过AMX、AVX等和AI相关的新的指令集来提高主频和性能,可实现芯片内部直接进行数据处理。对比上一代,尽管架构上没有太大改变,都支持AMX和AVX-512,但是因为内存IO部分的增强,AI推理能力也得到了增强。第五代相比第四代英特尔至强可扩展处理器,推理能力可以提升42%。

此外,LLC大小从1.875MB增加到5MB。过去英特尔的LLC基本上在1M-2M。这是英特尔第一次在第五代英特尔至强可扩展处理器,把LLC提升到5MB的水平。基于LLC和核数的提升,包括内存带宽的提升,带来了其他类型的增强,如NLP以及图像类AI的增强,同时支持20B参数以下的大语言模型,延迟可以低于100ms等。在性能能效方面,与第四代至强相比,SPEC integer有21%的提升。在预取相关的指令集方面,第五代至强相比第四代至强减少了超过18毫秒以上的内存访问延迟。第五代至强基于Intel 7制程,采用了Dual-poly-pitch SuperFin晶体管技术。该产品与上一代英特尔至强可扩展处理器相比,在核数和不同的性能指标上都有很大提升。

下面,我们来一一揭秘第五代志强处理器是如何实现这些性能指标的。

第五代至强架构剖析

芯片布局

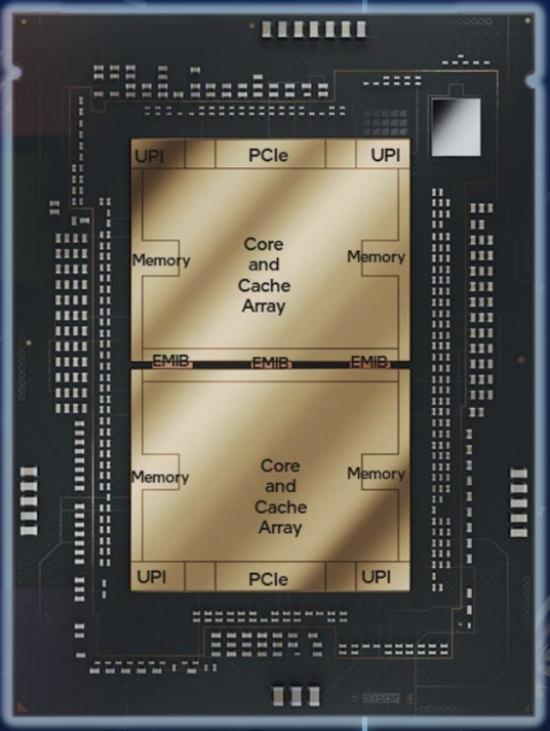

第四代至强把芯片分为相对对称的四个部分,而第五代至强的切分方式则做了调整,把切四份的做法变成了切两份。其内部是一个7×7的网格,中间是模块,包括CPU核心、三级缓存等。其中,东西两边是DDR接口,上面是PCIe、UPI,还有一些加速单元,中间一共有33个硅片。

其上下两个芯片是由7个500G全带宽的通路把上下两个芯片互连。虽然物理上,它们是两个分离的芯片,但通过增加两个交错互连,可以最大化的增加东西向的带宽的上线,避免出现任何带宽上的瓶颈。基于这样的高带宽连接,它们就可以实现一个逻辑上无缝连接。SCF是利用英特尔的2.5D封装技术,也就是EMIB(嵌入式多芯片互连桥接)来进行互连的,可实现芯片之间的高效互连。值得一提的是,第四代至强也采用的是EMIB技术进行互连。

英特尔资深技术专家介绍说:“这样的好处是,当需要切四份的时候,每两片之间相互进行通信时,需要有一些芯片互连之间的接口,这需要占用额外的芯片面积,同时也有额外的功耗。通过芯片质量控制,这种调整,可以支持在相对比较大的面积下得到很好的良率,并且通过把四片芯片改成两片芯片的设计,可以更好的对芯片的面积进行控制。”

三级缓存(LLC)

在英特尔的架构当中,存储分为Core和Uncore。所有CPU里的执行逻辑,不管是前端、后端,还是L1、L2 缓存,都算在Core的面积里;而LLC部分是算在Uncore里面。Core和Uncore都算在7×7的阵列模块当中。

LLC指的是LLC-data。缓存里面有两部分,一部分是data部分,还有一部分是TAG部分。在第五代志强处理器中,每个模块的LLC容量达到了5MB,所以这款芯片的缓存高达320MB。每个5MB的LLC是一个整体,这当中还包括两部分,即3.75MB的LSF和1MB的RSF。LSF是指一个核心有一个本地的L1和L2的Cache,另外一个核心也有本地的L1和L2的Cache,它们是用来做缓存一致性的。

英特尔资深技术专家分享说:“LLC采取了新的DEC和TED编码方式,也就是当在一个缓存行错两位的时候,还可以进行纠正,出现三位错的时候还可以去检测。这样比单位纠错和两位检错有了更强的纠错能力,大大提升了系统的容错性。还有数据修复方案,也提供了更多灵活性。”

内存IO

第五代至强速度从4800MT/s提升到5600MT/s。内存速度的增加,得益于很多方面的努力。其中在芯片设计方面,英特尔做了很多优化,包括一些MIM的内存、基板上走线的提升,以及片上的低噪声的供电措施等。

英特尔资深技术专家补充说到:“还有很大的一个功能叫4-tap的DFE功能,它可以把数据采集起来,用来做下一个bit接收的调整,可以尽可能的减少码间干扰(ISI)。那么不打开DFE和打开DFE,在5600MT/s这么高的速度下,也可以带来非常好的信号完整性的表现。”

核数增加带来的改变

众所众知,第五代至强处理器是从最多的60核升级到64核。英特尔资深技术专家表示,核数增加之后,“红利”最大的是科学计算和大数据。

其实,大数据对热数据要求不敏感,其采用的是MRU策略(Most Recently Used),处理完数据后便会清除数据。但是核数越多,它能够把一个大任务拆分得越细,即大家同时进行计算,速度会更快,核之间UPI总线也会越来越快。所以核数多少对于AI/大数据比较重要。

英特尔资深技术专家补充说:“当然,若是底层主频高了,内存带宽大了,4800MT/s提升至5600MT/s,那么大家都能获益,但特性还是有所不同。”

据介绍,在AI当中,AMX带来的提升更重要。除了传统的CPU普通核计算之外,第五代志强处理器还增加了英特尔® AMX加速器,专门针对矩阵运算。AMX和普通核之间的互联通信便是通过英特尔® UPI,比PCIe要快。其能够将许多矩阵运算从普通的CPU中卸载到AMX上,通过专用加速器处理专用的业务逻辑,性能便会大幅提升。所以面向AI时代,英特尔也在逐步优化CPU的架构。

英特尔资深技术专家形象的比喻:“对我来说,CPU更像是一个大侠,十八般武艺样样精通,一个人可以应对很多人,单打独斗能力很强。GPU更像是军队,每个人没有什么特色,但是人多,执行的任务简单且并发高,因为GPU业务逻辑非常简单,但是核数众多。”

英特尔始终致力于在CPU上部署AI,并基于OpenVINO对整个模型进行优化、量化,包括推荐、语音识别、图像识别、基因测序等,英特尔均做了大量的优化,尤其是推荐系统,其模型非常大,当GPU无法运行的时候,用CPU反而是主流的。英特尔资深技术专家解释说:“因为GPU不够的时候,就意味着需要跨GPU,或者说和CPU有频繁交互。那么,跟主存有频繁交互的时候,实际上使用CPU会更快。因此,对于推荐系统、大模型、稀疏矩阵等,用CPU效率更高。”

对于通用的AI工作负载,英特尔采用AMX和AVX-512两个指令集,基于OpenVINO进行优化。在推理的过程中,指令集上可以进行切分,通过加速器定向加速某一部分,整个效果替代传统的基于GPU的AI模型,这个完全没有问题。

除了上层的框架之外,英特尔开发了很多高性能库,比如oneDNN、OneCCL。OneDNN能把单机性能提升到最高,OneCCL则提供可以集群式做运算的可能,使得20B参数以上的模型在CPU的场景下做推理成为可能。有了oneDNN和oneCCL的加持,就可以在CPU上做大模型的推理。

那么,CPU做大模型的能力如何?

据英特尔资深技术专家介绍,从横向延迟的角度来看,基本上100ms是客户业务的阈值,大于100ms时业务体验就会差一些。因此,不同大小的模型需要不同的算力支持。如果卡在100ms的标准上,一颗第四代或第五代英特尔至强可扩展处理器可以支持13B参数的模型。两颗可以做到30B参数的模型,如果想要更短的延迟,只要把模型缩小就可以,而对于6B或者是7B参数的模型,一颗第四代英特尔至强可扩展处理器可以做到60ms,在oneCCL的加持下的分布式推理,则可以支持更大的模型。

对于大模型来说,基本上所有计算都是在GPU的显存上进行的,但还有一种应用是视频的前处理,比如现在比较火的窄带高清,大家主流的做法是在CPU侧做视频解码,然后把图像传给GPU,GPU做AI图像增强的预处理,再把数据传给CPU做编码,再通过视频流出去。

英特尔资深技术专家介绍说:“这一整套的架构是比较复杂的,因为我们需要调度FFmpeg和AI算法,因此内存复制的次数比较多,导致整个算法和流程都要根据异构定制,整个GPU的利用率也不是很高。在这样的情况下,我们有没有可能把这一部分AI预处理的工作移到CPU侧,把所有的流程都放在CPU上进行,也就是做好视频解码之后,直接利用CPU中AMX的能力,完成图像增强和编码。”

英特尔资深技术专家分享了英特尔和百度一起,使用四台基于第五代英特尔至强可扩展处理器的双路服务器,一共8颗第五代至强芯片,就可以支持70B参数的模型,中间的互连采用oneCCL和RDMA网络。由此可见,CPU也可以做70B参数模型的推理,并且延迟可以达到100ms以内。所以,GPU并非是大模型的唯一选择,CPU也有能力做同样的事。

CPU另一大优势是灵活,无论是业务扩容还是通过分布式快速地获取部分资源,都不受限制。除了大模型之外,其实CPU还有很强的能力去构建整个流程的应用,没有必要做异构,CPU即可完成所有的工作。

结束语

除了以上介绍的性能提升和功能增强之外,第五代英特尔至强可扩展处理器还有一个非常重要的特性叫TDX,即整个安全环境的部署。TDX对于AI来讲也非常重要,因为有一些客户想要上云来很好地保护自己的数据,TDX就是一个非常好的安全环境实例,可以让客户把他的AI应用部署在公有云上。

庄秉翰分享:“未来,底层能源的利用率便是企业最大的优势,谁的能源利用率高,转化率高,谁就更有竞争力。我们将推出P-core(性能核)和E-core(能效核)处理器,其中P-core看重整体性能的提升,而E-core则看重每瓦带来的性能提升。”