速度快10倍,Groq芯片一夜爆红!英伟达要被赶下神坛?

2024-02-21 11:46:28 EETOP

Groq名字与马斯克的大模型Grok读音类似,成立于2016年,定位为一家人工智能解决方案公司。

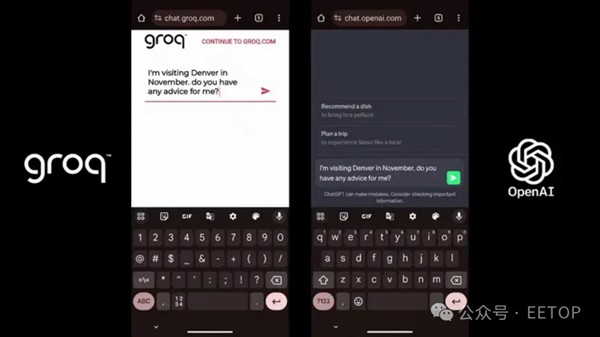

Groq爆火主要是因为其处理速度非常快。据媒体报道,该公司的芯片推理速度较英伟达GPU提高10倍,成本只有其1/10。

运行的大模型生成速度接近每秒500 tokens,碾压ChatGPT-3.5大约40 tokens/秒的速度。

极限情况下,Groq的Llama2 7B甚至能实现每秒750 tokens,为GPT-3.5的18倍。

在Groq的创始团队中,有8人来自谷歌早期TPU核心设计团队,但Groq并未选择TPU、GPU、CPU等路线,而是自研了语言处理单元(LPU)。

Groq官网显示,在 Groq LPU™推理引擎上运行的Meta AI的Llama 2 70B的性能优于所有其他基于云的推理提供商,吞吐量提高了18倍。

能否取代英伟达?

不过,速度并不是AI发展的唯一决定性因素。在Groq爆火的同时,也有一些质疑声音。

首先,Groq似乎只是看起来便宜。Groq的一张LPU卡仅有230MB的内存,售价为2万多美元。

有网友分析,英伟达H100的成本效益应为Groq的11倍。

更为关键的是,Groq LPU完全不配备高带宽存储器(HBM),而是仅配备了一小块的超高速静态随机存取存储器(SRAM),这种SRAM的速度比HBM3快20倍。

这也意味着,与英伟达的H200相比,在运行单个AI模型时需要配置更多的Groq LPU。

另据Groq员工透露,Groq的LLM在数百个芯片上运行。

对此,腾讯科技的芯片专家姚金鑫认为,Groq的芯片目前并不能取代英伟达。

以下是姚金鑫转写的文章:

有关Groq芯片跑大模型超越英伟达芯片的文章火爆了朋友圈,这是个非常好的案例来科普,甚至反思一些现象。

首先,从技术上解释还原一下这件事情的本来面目,然后基于这件事情,表达几个对背后引人深思现象的看法。

一、速度快,但成本奇高

技术上解释:

几个关键信息点:SRAM的容量是230MB,带宽80TB/s,FP16的算力是188TFLOPs。

按照当前对大模型的推理部署,7B的模型大约需要14G以上的内存容量,那么为了部署一个7B的模型,大约需要70片左右的芯片,根据透露的信息,一颗芯片对应一张计算卡,按照4U服务器配置8张计算卡来计算,就需要9台4U服务器(几乎占了一个标准机柜了),总共72颗计算芯片,在这种情况下,算力(在FP16下)也达到了惊人的188T * 72 = 13.5P,如果按照INT8来算就是54P。54P的算力来推理7B的大模型,用大炮打蚊子来形容一点也不为过。

如果是英伟达,朋友圈文章对标的是H100,其采用的是80G的HBM,这个容量可以部署5个7B的大模型实例;我们再来看算力,稀疏化后,H100在FP16下的算力将近2P,在INT8上也将近4P。

那么就可以做个对比,如果从同等算力来看,如果都是用INT8来推理,采用Groq的方案需要9台包含72片的服务器集群,而如果是H100,达到同等算力大约需要2台8卡服务器,此时的INT8算力已经到64P,可以同时部署的7B大模型数量达到80多个。原文中提到,Groq对Llama2-7B的Token生成速度是750 Tokens/s,如果对标的是H100服务器,那这2台总共16颗的H100芯片,并发吞吐就高到不知道哪里去了。如果从成本的角度,9台的Groq服务器,也是远远贵过2台H100的服务器(即使此刻价格已经高到离谱),

Groq:2万美金72=144万美金,服务器2万美金9=18万美金,纯的BOM成本160万美金以上(全部都是按照最低方式来计算)。

H100: 30万美金2 = 60万美金(国外),300万人民币2=600万人民币(国内实际市场价)

这还没有算机架相关费用,和消耗的电费(9台4U服务器几乎占用整个标准机柜)。

如果是70B的模型,同样是INT8,要用到至少600张卡,将近80台服务器,成本会更高。

实际上,部署推理性价比最高的,恰恰是4090这种神卡。

二、速度,在这里成了Groq的双刃剑。

可是为什么Groq和自媒体都有意无意地引导人们已经超越英伟达了呢?并且大多数人都还相信了呢?

这首先是因为英伟达在本次AI浪潮中的绝对领先地位,使得全球都翘首以盼挑战者。每次吸引眼球的文章,总会在最初被人相信,除了这个原因之外,还是因为在做对比时的“套路”,故意忽略其他因素,用单一维度来做比较。这就好比那句名言“抛开事实不谈,难道你就没有一点错的地方吗?”

抛开场景来谈对比,其实是不合适的。对于Groq这种架构来讲,也有其尽显长处的应用场景,毕竟这么高的带宽,对许多需要频繁数据搬运的场景来说,那就是再好不过了。

总结起来,Groq的架构建立在小内存,大算力上,因此有限的被处理的内容对应着极高的算力,导致其速度非常快。

现在把句话反过来,Groq极高的速度是建立在很有限的单卡吞吐能力上的。要保证和 H100同样吞吐量,你就需要更多的卡。速度,在这里成了Groq的双刃剑。

关键词: Groq