三星论文揭秘Exynos 9820 NPU核心技术,未来将应用于存储器和传感器

2019-07-05 09:48:21 雷锋网

深度学习算法是人工智能的核心要素,因为它们是让计算机能够像人类一样思考和学习的过程。神经处理单元(NPU)是针对深度学习算法计算而优化的处理器,旨在同时有效地处理数千个深度学习计算。

三星电子上月宣布,通过扩大NPU技术开发,到2030年加强其在全球半导体行业的领导地位。三星最近在计算机视觉领域的顶级学术会议之一的CVPR(Computer Vision and Pattern Recognition)上更新了更多信息。

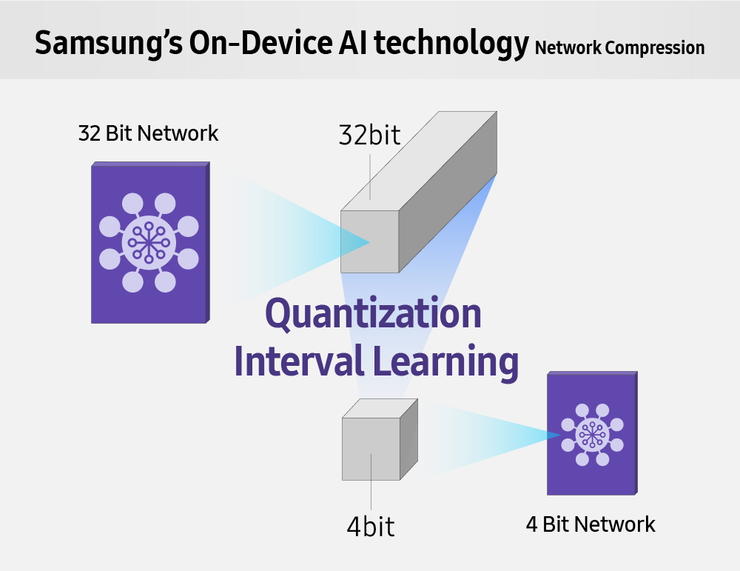

此更新是三星的嵌入式AI轻量级算法,在CVPR上引入了一篇题为《Learning to Quantize Deep Networks by Optimizing Quantization Intervals With Task Loss》(可翻译为《通过优化量化间隔,借助任务损失学习量化深度神经网络》)的论文。嵌入式设备的AI能力可以直接计算和处理数据,最新的算法解决方案比现有算法轻4倍、速度快8倍,主要目是解决终端AI的低功耗和高性能问题。

简化深度学习过程

三星高级技术研究院(SAIT)宣布他们已经成功开发了嵌入式(On-Device)AI轻量级技术,其计算速度比现有的32位服务器深度学习数据快8倍。通过将数据调整为4位以下的组,在保持准确数据识别的同时,还能比现有深度学习算法更快,更节能。

三星新的嵌入式AI处理技术通过“学习”确定影响深度学习整体成绩的重要数据的时间间隔。这种“量化间隔学习(QIL)1”通过重新组织,以小于其现有大小的比特位呈现的数据来保持数据准确性。SAIT进行的实验成功地证明了在计算到小于4位的水平时,32位间隔内的服务器深度学习算法的量化如何提供比现有其它解决方案更高的精度。

当深度学习计算的数据以低于4位的位组表示时,除了加法和乘法的算术计算之外,还允许进行'和'和'或'逻辑运算。这意味着使用QIL的计算可以获得与现有过程相同的结果,但只需要1/40至1/120甚至更少的晶体管。

由于该系统只需要较少的硬件和供电,可以将其直接安装在获得图像数据或指纹传感器中。

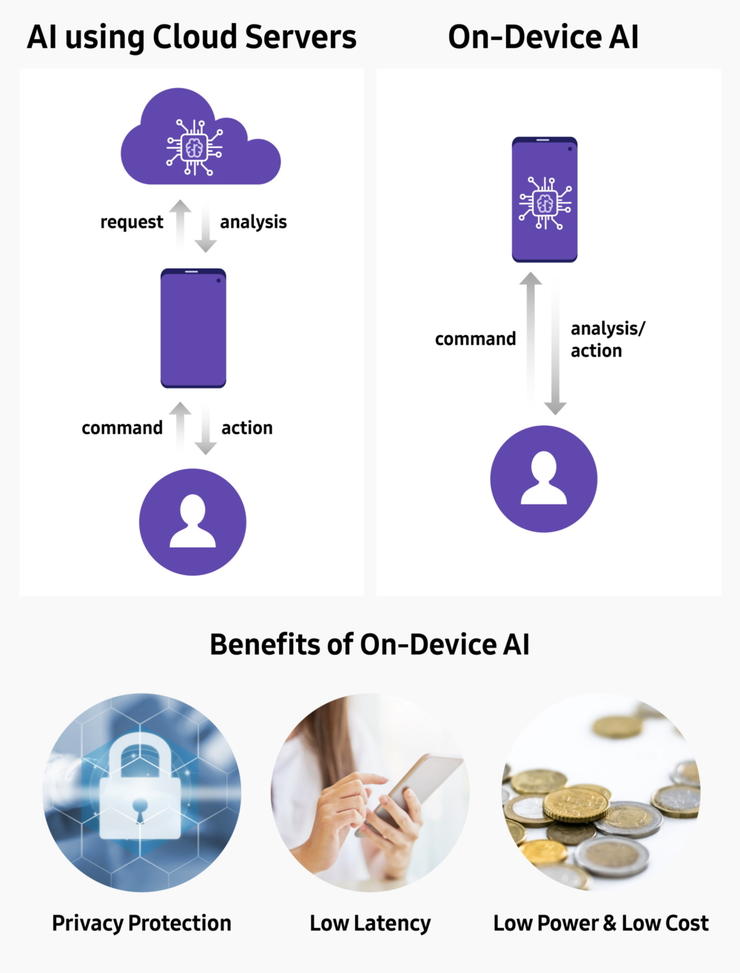

该技术将有助于增强三星的半导体实力,也有利于加强其在AI时代的核心竞争力之一 ——嵌入式这被的AI处理。与使用AI云服务不同,嵌入式AI技术直接处理设备本身获取的数据。

嵌入式设备上的AI技术可以降低建设云服务器的成本,因为它可以自主运行,并为虚拟现实、自动驾驶等应用提供快速稳定的性能。此外,嵌入式的AI技术可以用于本地个人生物信息(例如指纹,虹膜和面部扫描)认证,能够保证安全性。

嵌入式AI技术的核心功能是能够高速运算而不消耗过多的能量。三星的第一个解决方案是去年发布的Exynos 9(9820),这个SoC采用了三星专有的NPU。

在NPU的支持下,Exynos9820相比Exynos9810人工智能性能提升7倍,并可以增强从照片到AR的性能。

“未来我们将生活在一个所有设备和传感器都由AI驱动的世界中,”SAIT计算机视觉实验室副总裁兼负责人Chang-Kyu Choi说。“三星的嵌入式AI技术未来将不仅应用于移动SoC,还将应用于存储器、处理器和传感器市场,以及其它新的市场。“

免责声明:本文由作者原创。文章内容系作者个人观点,转载目的在于传递更多信息,并不代表EETOP赞同其观点和对其真实性负责。如涉及作品内容、版权和其它问题,请及时联系我们,我们将在第一时间删除!