EETOP翻译自semiengineering

芯片制造商正在研究新的架构,这些架构可显着增加每瓦功耗和每个时钟周期可处理的数据量,从而为数十年来芯片架构的最大转变奠定了基础。

所有主要的芯片制造商和系统供应商都在改变方向,引发一场架构竞赛,其中包括从存储器中读取和写入数据的方式到数据处理和管理的方式,以及最终在单个芯片上的各种单元被封装在一起。虽然半导体制造的节点缩减将继续,但没有人愿意进行扩展以跟上传感器数据的爆炸性增长以及机器之间的流量增加。

Rambus公司的杰出发明家Steven Woo说:“有一些趋势让人们试图充分利用他们已经拥有的东西。”在数据中心,你想从硬件和软件中挤出尽可能多的空间。这就是数据中心重新思考经济问题的方式。启用新功能非常昂贵。但是瓶颈正在转移,这就是为什么你会看到专门的芯片以及提高计算效率的方法。如果你能够阻止在内存和I / O上来回发送数据,这会产生很大的影响。”

这些变化在边缘上更为明显,而且就在边缘之外,系统供应商突然意识到数百亿台设备会产生太多数据,无法将所有内容发送到云端进行处理。但是在边缘处理所有这些数据会增加其自身的挑战,需要在不显着改变功率预算的情况下实现性能的巨大改进。

英伟达(Nvidia)的特斯拉首席平台架构师罗伯特•奥伯(Robert Ober)表示:“新的重点是降低精度。”“这不仅仅是更多的计算周期。它更多的是在内存中进行数据打包,使用16位指令格式。所以这并不是为了提高效率而在缓存中存储更多的数据。从统计学上讲,结果在两方面都是一致的。”

Ober预测,通过一系列的架构优化,在可预见的将来,每隔几年就可以将处理速度提高一倍。 “我们将看到技术的进步。” 他说:。“为了实现这一目标,我们必须处理三各方面:一个是计算,第二个是存储。在一些模型中,这是内存访问。有些则是计算。第三个方面是主机带宽和I/O带宽。我们需要在优化存储和网络方面做大量工作。”

其中一些已经在实施中。在2018年Hot Chips大会上,三星奥斯汀研发部门的首席架构师杰夫•鲁普利(Jeff Rupley)在发言中指出了该公司M3处理器的几个重大架构变化。一个涉及每个周期更多的指令 - 六个,而之前的M2为四个。再加上分支预测,这基本上是几个神经网络在搜索中做的相当于预取的工作,指令队列的深度是它的两倍,挑战就开始显现出来。

从另一个角度来看,这些变化将创新的纽带从制造和工艺技术转移到前端的架构和设计,以及后端的制造封装。虽然处理技术将继续创新,但在每个新节点上仅提高15%至20%的性能和性能是非常复杂的——而且这还远远不足以跟上数据的大幅增长。

Xilinx的总裁兼首席执行官Victor Peng在Hot Chips的演讲中说:“变革正以指数速度发生。每年将产生10 zettabytes[10的21次方字节]的数据,其中大部分是非结构化数据。”

内存中的新方法处理这么多数据需要重新思考系统中的每个组件,,从数据处理方式到数据存储方式。

“已经有很多尝试创建新的内存架构,” eSilicon EMEA创新高级主管CarlosMaciàn说。“问题是你需要读取每一行并在每一行中选择一位。另一种方法是构建可以从左到右,上下读取的内存。你还可以更进一步,将计算添加到不同的存储器中国。”

这些变化包括改变读取内存的方式、位置和处理元素的类型,以及使用人工智能对数据在系统中存储、处理和移动的方式和位置进行优先级排序。

“如果我们在稀疏数据的情况下一次只能从该数组中读取一个字节,或者在相同的字节通道中可能只有8个连续字节,而不使用与其他字节或字节通道相关的所有能耗,那么我们是什么呢?不感兴趣,“ Cadence产品营销集团总监Marc Greenberg说。“未来可能更适合这种事情。例如,如果我们看一下HBM2的架构,HBM2芯片堆栈被安排到16个64位的虚拟通道中,我们只需要从任何虚拟通道的任何访问中获得4个连续的64位字。因此,有可能构建1,024位宽的数据阵列并水平写入,但一次只读取64位×4个字。”

内存是冯•诺依曼体系结构的核心组件之一,但它也正在成为最大的实验领域之一。AMD的客户端产品首席架构师Dan Bouvier表示:“虚拟内存系统是一个大问题,在这个系统中,数据的传输方式更加不自然。如果你能消除DRAM中的Bank冲突,你就能获得更高效的数据流。因此,离散GPU可以在90%的效率范围内运行DRAM,这是非常高的。但如果你能得到流畅的数据流,你也可以在80%到85%的效率范围内运行APU和CPU。”

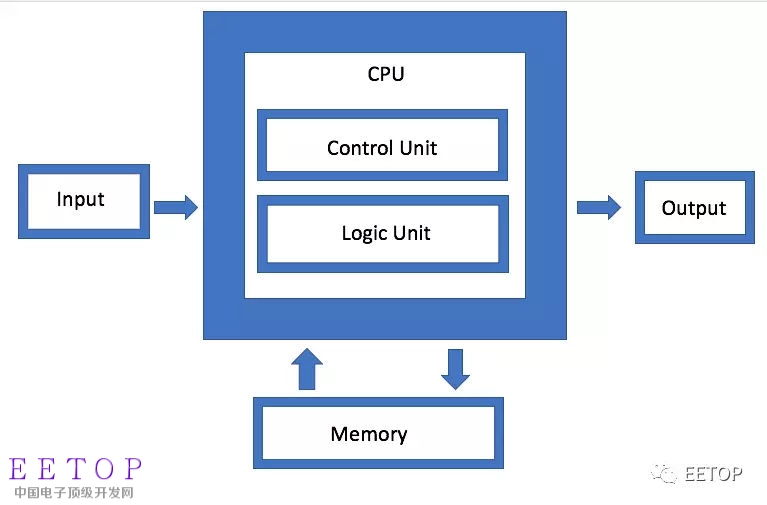

图1:冯·诺依曼架构

IBM正在开发一种不同的内存体系结构,它本质上是磁盘阵列的现代版本。IBM的系统硬件架构师杰夫•斯图切利(Jeff Stuecheli)将连接技术称为连接的“瑞士军刀”,其目标不是局限于单个磁盘,而是巧用可用的任何内存。这种方法的优点是可以混合和匹配不同类型的数据。

“CPU变成了一个位于高性能信号接口中间的东西,”Stuecheli说。“如果你修改微体系结构,核心可以在每个周期做更多的事情而不需要增加频率。”

连接性和吞吐量对于确保这些体系结构能够处理所生成的数量庞大的数据变得越来越重要。“现在最大的瓶颈在于数据流动,”Rambus'Woo说。“业界在实现更好的计算方面做得非常出色。但是,如果你正在等待数据或专用数据模式,则需要更快地运行内存。因此,如果你看一下DRAM和NVM,性能取决于流量模式。如果对数据进行流处理,就可以从内存中获得非常好的效率。但如果数据在空间中随意跳跃,效率就会降低。无论你做什么,随着体积的增加,你都要做得更快。

更多的计算,更少的移动使问题复杂化的是,边缘设备以不同的频率和速度生成多种不同类型的数据。为了使数据在各种处理单元之间平滑移动,必须比过去更有效地管理它。

“有四种主要配置 - 多对多,内存子系统,低功耗Io,以及网状和环形拓扑,” ArterisIP董事长兼首席执行官Charlie Janac说。“你可以将所有这四个放在一个芯片中,这就是决策IoT芯片所发生的事情。或者你可以添加具有高吞吐量的HBM子系统。但复杂性是巨大的,因为其中一些工作负载非常具体,每个芯片有多个工作负载和引脚。如果你看一些这些物联网芯片,他们会收集大量的数据。对于像汽车中的雷达和LiDAR这样的东西尤其如此。没有某种先进的互连,它们就不可能存在。”

挑战在于如何最小化数据移动,同时在需要时最大化数据流,并以某种方式在不使用太多功率的情况下实现本地和集中处理之间的平衡。

NetSpeed Systems的产品营销经理拉杰什•拉曼努贾姆(Rajesh Ramanujam)表示:“一方面是带宽问题。”“如果可能的话,尽量不移动数据,因此可以将数据移动到更靠近处理器的地方。但如果必须移动数据,则需要尽可能地压缩数据。然而,这一切都不存在于真空之中。所有这些都必须从系统级别进行观察。每个步骤都需要考虑多个顺序轴,它决定了您是使用传统的读写方式使用内存,还是使用新的内存技术。在某些情况下,您可能希望更改存储数据本身的方式。如果您想要更快的性能,这通常意味着更高的芯片面积成本,但这会影响到功耗。现在你要考虑功能安全,还要担心数据过载。

这就是为什么在边缘处理和不同处理元素之间的吞吐量有如此多的关注。但是,随着架构的开发和改进,如何以及在哪里实现这些处理的方式将会有很大的不同。

举个例子:Marvell引入了一个内置人工智能的SSD控制器,这样它就可以在边缘处理更大的计算负载。人工智能引擎可以用于固态存储本身的分析。

“你可以直接将模型加载到硬件中,并在SSD控制器中进行硬件处理,”Marvell的首席工程师内德瓦尔尼察说。今天,云端的主机就是这样做的。但是,如果每个驱动器都将数据发送到云端,就会产生大量的网络流量。最好是在边缘进行处理。因此,你拥有的存储设备越多,处理能力就越强。减少数据移动的好处是巨大的。”

这种方法特别值得注意的是,它强调了数据移动的灵活性,这取决于应用程序。因此,主机可以生成一个任务并将其发送到存储设备进行处理,之后仅返回元数据或计算结果。在另一种情况下,存储设备可以存储数据、对其进行预处理和生成元数据、标记和索引,然后由主机检索,以便进行进一步的分析。

这是一种选择,还有其他的做法。三星的Rupley强调了无序处理和融合的习惯用法,它们可以解码两条指令并将它们融合到一个操作中。

AI监督和优化所有这些都是人工智能,这是进入芯片架构的真正新元素之一。这种疏忽不是让操作系统和中间件管理功能,而是围绕芯片,芯片之间和系统级分布。在某些情况下,这可能包括芯片内的神经网络。

eSilicon公司营销副总裁迈克·吉安法尼亚说:“与其说你如何将更多的东西组合在一起,不如说你改变了做事的传统方式。”“通过人工智能和机器学习,你可以把所有这些东西撒在一个系统周围,以获得更高效和更有预测性的处理。”在其他情况下,它可能涉及到独立于系统或封装内独立运行的独立芯片。”

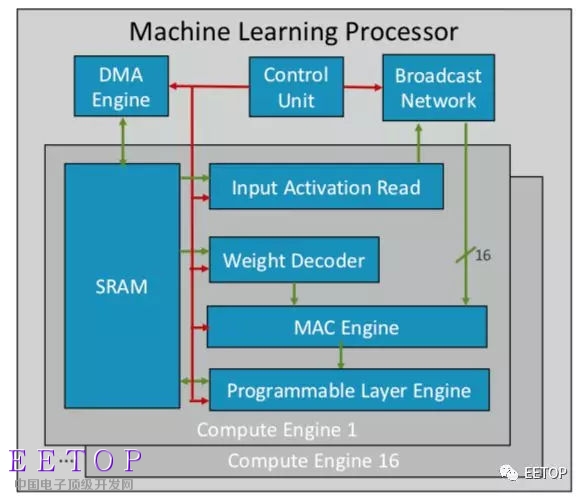

Arm透漏了其首款机器学习芯片计划,将于今年晚些时候在多个市场领域和垂直领域推出。Arm杰出工程师伊恩•布拉特表示:“这是一种新型处理器。”它包括一个基本模块,这是一个计算引擎,加上一个MAC引擎,一个具有控制联合和广播网络的DMA引擎。总共有16个计算引擎,使用7nm工艺技术,在1GHz可以运行4万亿次。

由于Arm是在合作伙伴的生态系统中提供IP,因此其芯片更通用,可配置为正在开发的其他AI / ML芯片。它不是将所有内容构建为整体结构,而是按功能划分处理,因此每个计算引擎都在不同的特征映射上工作。Bratt表示,四个关键要素是静态调度,高效卷积,带宽减少机制以及面向未来设计的可编程性。

图2:Arm的ML处理器架构

与此同时,Nvidia采取了不同的策略,在GPU旁边构建专用的深度学习引擎,以优化处理图像和视频的流量。

结论通过利用部分或全部这些方法,芯片制造商表示,他们每两年可以将性能提高一倍,跟上数据爆炸的步伐,同时保持在电力预算的严格限制范围内。但这不仅仅是提供更多的电脑。它正在改变芯片设计和系统工程的起点,从越来越多的数据开始,而不是硬件和软件的限制。

Synopsys董事长兼联席首席执行官Aart de Geus表示,“当电脑进入企业时,很多人都认为世界的发展速度要快得多。” “他们用一堆会计账簿对纸张进行会计处理。那是一个指数变化,现在我们再次看到它。什么是发展 - 这可能会给它一种更快的感觉 - 你可以从某种程度上理解穿孔卡片的会计账簿,并将其打印出来并进行计算。在心理上,你可以遵循每一步。事实上,在一个农业领域,你只需要在某一天的温度上升这么多,就需要浇水和某种肥料,这是机器学习的结合,这是一种优化,在过去并不明显。

“新的架构将被接受,” 西门子 Mentor总裁兼首席执行官沃利•莱恩斯(Wally Rhines)表示。它们将被设计成在很多情况下,会有机器学习,因为你的大脑有能力从经验中学习。我走访了20多家公司,它们都有各自的专用人工智能处理器。但是你会越来越多地在特定的应用中看到它们,它们将补充传统的冯·诺依曼架构。神经形态计算将成为主流,它是我们下一步如何提高计算效率,降低成本,在移动和连接环境中做事情的一个重要组成部分。”

(翻译水平有限,勿喷,附原文地址:https://semiengineering.com/big-changes-for-mainstream-chip-architectures/)